作者:周才忠 (日期:2025/6/29)

『電腦科學』和『人工智慧』(AI)之父-艾倫·圖靈曾說過一句名言:「我們只能看到前方很短的距離,但我們可以看到那裡有很多事情要做」。『人工智慧』的最新發展正在徹底改變各個專業領域的相關實務,如果「評估」人員未能利用新科技帶來的機遇,「評估」領域將面臨生存風險。因此,本文介紹的主題,包括『人工智慧』的發展進程、定義與概念、『科學』觀點、SWOT分析、應用實例、倫理議題和未來方向等內容。AI對於「評估」專業領域的巨大衝擊,不會在遙遠的未來實現,它已經是正在發生的進行式了。而我們要向下一代的專業人士/學生傳授什麼?還是那些傳統的由上而下、專家權威、菁英觀點、便宜行事、虛有其表、蕭規曹隨、機械式思考嗎?!

『人工智慧』的發展進程

『人工智慧』(Artificial Intelligence)(以下簡稱「AI」),它是一種由人們製成具有知覺、綜合與推斷「信息」等智慧的「機器」。其功能包括語音辨識、電腦視覺、語言轉譯以及其他輸入繪圖。1990年代,開始結合『認知科學』領域」發展出「人工神經網路」。約莫2000年後,更進展到具備「深度學習」功能,如臉部與表情辨識。接續2010年,這股AI新潮流搭上『巨量資料科學』(*大數據)(Big Data)的子彈列車,研發出「現代情感語意分析」、「大型語言模組」(LLM)等。

2022年10月,由美國一家開放AI研究實驗室(OpenAI),開發出來的聊天機器人程式─「ChatGPT」,它可以透過與使用者的巧妙對話,提供更廣泛的常識以及能客製化準確地解決疑難問題。這股方興未艾的「運算革命」(Computing revolution)的新潮流,對於「方案評估」的實務上,有何重要角色與相對影響呢?總括來說,就是改變了“遊戲規則”(周才忠,2024)。

AI的最新發展正在徹底改變各個專業領域的專業實務,「評估」領域也不例外。憑藉其先進的自動化和學習能力,AI正在顯著改變組織和社會的運作方式。儘管「評估」人員採用AI的速度較慢,但「評估」工作也未能逃脫這一趨勢的影響。如果「評估」人員未能利用新科技帶來的機遇,「評估」領域將面臨生存風險。對此,「國際影響力評估倡議」(3ie)高級研究員-邁克爾·班伯格設想了一個悲觀的情景:「評估」將被邊緣化,並被其他整合新技術以充分利用大數據潛力的管理實務所取代(Bamberger, 2020)(轉引自Jacob, 2025)。

目前,「機器學習」(以下簡稱「ML」)和AI在各個領域的「方案評估」中都發揮著關鍵作用。ML是AI的一個分支,它運用統計技術,使機器能夠透過經驗提升其性能(Izdihar et al., 2021)。ML是AI的一個重要面向,它使軟體應用程式無需明確「編程」(programming)即可改善預測結果(Lohit, Mujahid, & Sai, 2022)。AI和ML在包括「方案評估」在內的各個專業都取得了顯著進展,使電腦能夠從數據中學習和改進,而無需明確「編程」(Mueller, Kinoshita, Peebles, Graber, & Lee, 2022)(轉引自Shapiro & Lam, 2025)。

『人工智慧』的定義與概念

1956年,在美國東北部新罕布夏州達特茅斯學院的夏季AI研究計劃提案中,由約翰·麥卡錫及其合作者(McCarthy et al., 2006)創造了「AI」這個術語。其定義是,機器可以被製造來模擬「學習的各個方面或智慧的任何其他特徵」。作為智慧的特徵,麥卡錫等人......引用語言的使用、抽象和概念的形成、解決現在人類獨有的問題以及自我改善。然而,「智慧」本身是一個備受爭議的概念,目前尚不清楚AI需要複製哪種或誰的「智慧」才能配得上被稱為AI。由於AI概念的微妙性,導致了許多相互競爭的定義,涵蓋了各個面向(Kaplan & Haenlein, 2019)(轉引自Stahl, 2021)。

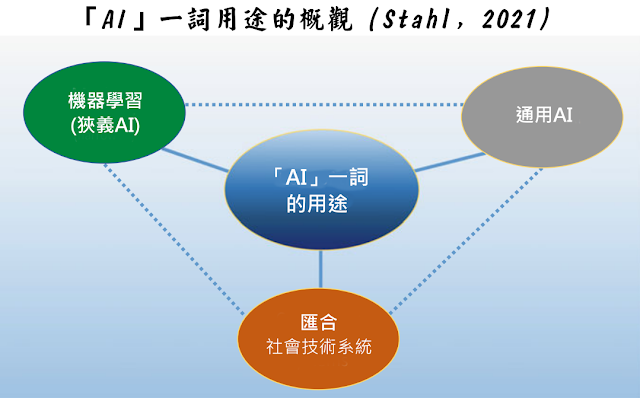

- 「機器學習」是狹義AI的關鍵範例,即一種能夠成功複製特定認知過程的技術。「機器學習」自誕生以來就一直是AI研究的重要組成部分(Bishop, 2006),但近年來運算能力的提升和數據可用性的提高,使其在眾多領域的應用蓬勃發展。「機器學習」涵蓋了廣泛的技術和方法,包括監督式學習、貝氏決策理論(Bayesian decision theory)、各種參數和非參數方法、集群等等(Alpaydin, 2020)。

- 「通用AI」(有時也稱為「強AI」)起源於AI研究的早期階段,其理念是建構能夠展現人類(或其他高等哺乳動物)真實智力水準的系統。它也被稱為“美好老式AI”(GOFAI)。 GOFAI最初的宗旨是,世界可以用「符號」來表示,並且對這些「符號」的操控將導致智慧行為(Moor & Bynum, 2002)。在這種觀點下,人腦被視為一台執行邏輯運算的電腦,而相同或至少功能等效的運算可以在數位電腦中執行(Floridi, 1999)。

- AI是匯合「社會技術系統」的同義詞,它包含但遠遠超出了狹義AI技術。許多『科學』技術領域與AI密切相關,在AI的討論中也經常被提及。其中一些技術能夠產生「機器學習」所需的數據,例如物聯網。另一些技術則能夠幫助AI影響世界,例如「機器人技術」(European Commission, 2020)。人們也可以使用「智能資訊系統」(SIS)一詞來表示這種多種技術的組合,這些技術通常是基於「機器學習」和「大數據分析」(Stahl & Wright, 2018)。在實務中,AI很少作為一項獨立的技術出現,而是通常與其他技術相互關聯並嵌入其中。

1880年創立且專注於『科學』、「技術」和『醫學』(如《刺胳針》)內容的荷蘭學術出版商Elsevier,在2018年曾針對對AI文獻進行了回顧,指出構成AI學科的許多關鍵概念和研究領域。該報告基於60萬份的AI相關文獻樣本,並根據800個關鍵字進行分析,將AI出版物分為七大類(轉引自Stahl, 2021):

- 搜尋與優化

- 模糊系統(fuzzy systems)

- 規劃與決策

- 自然語言處理(NLP)與知識表徵

- 電腦視覺

- 機器學習

- 機率推理與神經網路

這強調了AI並非單一技術,而可以更好地理解為一系列技術和子學科(Gasser & Almeida, 2017)(轉引自Stahl, 2021)。

『人工智慧』的『科學』觀點

人類「心智」(Mind)極為複雜,難以捉摸,『心理學』一直對此著迷。然而,其深度仍然鮮為人知,稀缺的資訊和武斷的解讀阻礙了我們的理解。如今,AI已成為一股強大的力量,有望揭示這些隱藏的複雜性。AI驅動(AI-powered)的演算法能以驚人的客觀性和精確度分析大量數據,例如語音模式、臉部表情,甚至生理指標。對於那些因社會或地理限制而無法獲得傳統治療的患者,AI聊天機器人和虛擬治療師可以提供全天候的支持和指導。這些AI模型模擬人類的知覺、學習、記憶和決策,為理解大腦背後的複雜機制提供了重要的見解。這種深入的知識,對於制定更有效應對各種心理健康問題的介入措施和「預防」策略至關重要。為了確保適當且合乎「倫理」的應用,必須在AI的優勢和人類連結不可或缺的溫暖之間取得平衡(Bajotra & Rani, 2024)。

『生成式人工智慧』(Generative Artificial Intelligence)(以下簡稱「GAI」)是一個涵蓋廣泛AI模型和技術的術語。GAI代表機器無需人工介入即可自主創建數據和資訊的能力(Wang et al., 2017)。這與傳統的「方案評估」方法形成了鮮明對比,後者需要人工輸入資料才能評估結果(Mondal et al., 2023)。此外,GAI模型可用於從各種來源產生數據,包括文獻綜述、「行動應用程式」(手機App)和電腦輔助系統(Wu et al., 2022; Zhang et al., 2023; Koshino et al., 2021; Xu et al., 2014)。GAI正越來越多地應用於從醫學教育到交通模擬等眾多領域。例如,已經開發出一款名為「TrafficGAN」的行動應用程式來產生逼真的交通數據(Wu et al., 2022)。此外,GAI模型也用於電腦輔助系統,以增強訓練資料並提高準確性(Koshino et al., 2021)。GAI也用於AI領域,用於訓練深度神經網路(Xu et al., 2014)。GAI與傳統「方案評估」的關鍵差異在於資料生成的方式(Zhang et al., 2023)。具體來說,GAI模型涉及分佈參數和假設的估計(Wang et al., 2017),而傳統方法則依賴人工的手動輸入(Mondal et al., 2023)。總而言之,GAI是一個新興領域,它有可能徹底改變我們「評估」方案與其結果的方式(轉引自Patel, 2023)。

資訊世界由『數位科技』所中介,AI透過其對日常生活的介入對社會日益增長的影響,很可能帶來一些具有持久影響的問題。在利用AI改善「社區幸福」(Community well-being)的脈絡下,激活此類改善所需的知識、洞察力、印象或分析需要一個參照框架。該框架需要考慮在當前「技術創新」作為經濟成長驅動力的典範下,如何理解「幸福」。「幸福」的「評估」通常被定義為個人對生活的認知和情感評估,它基於對滿足感和成就感的認知,考慮了對事件的情緒反應。它是一個動態概念,涉及主觀、社會和心理維度,以及一種滿足人類需求並能夠做出有意義行動的狀態,從而凸顯了「社會幸福」和「社區幸福」背後的關係要素。從以「工業」為主的社會,朝向以「資訊」為主導的社會的轉型,我們需要對AI進行策略性的「社會設計」(Social design)(Narayan, 2020)。

「大數據」在測量向度上,可涵蓋廣泛的「幸福」構念,包括生活滿意度、正向/負面情緒以及同理心/信任特質。並能進一步去檢視人們心理健康與幸福感相關有意義的變化過程(每週或跨年尺度)。也許,「社交媒體」最有前瞻之處,在於它日益擴大的數據規模、追溯功能與多層結構靈活性,允許將地理空間與時間的測量,能夠細化到「縣市─月份」粒度。這樣的樣本大小與間隔,十分適合用來檢定相關「準實驗設計」的研究假設(如「幸福」的決定因子與影響結果)。然而,「社交媒體」如果是一個「評估」幸福感的有效方式,則需要考量其數據的收集、聚合與加權方面(如「資料探勘」),以及如何從「非結構化語言」中得出人群心理狀態的估計結果(如現代情感語意分析、大型語言模組LLM、機器學習模型ML)。還包括縱向穩定性、外在效度等等。這些幸福感的「大數據」分析方法,很多初步開發工作都是在美國進行的,例如蓋洛普民調公司歷年幸福感調查資料、訓練與基準化測試模組、諸多實驗室的研究結果。未來,亦可在世界不同國家來實施,以建立更有信效度且具即時性的「幸福指標系統」(Kjell et al., 2023)。

『人工智慧』應用於「方案評估」的SWOT分析

應用概述

Shapiro和Lam(2025)概述了將AI和ML融入「方案評估」的六種方法,旨在透過數據驅動(data-driven)的洞察力和更高的效率來增強傳統方法。這些方法旨在滿足「評估」人員日益增長的對複雜資料集的精準分析需求,同時減少人工操作。這些方法包括:(1)識別數據模式以發現趨勢和異常值;(2)使用預測模式預測結果;(3)透過「績效分析」精準定位可改進的範圍;(4)透過「視覺化」以簡化資料解讀;(5)「自動化資料分析」以提高效率;(6)以及利用數據儀表板或控制面板進行即時監控和決策。Shapiro和Lam強調,雖然它並未為技術專業知識有限的「評估」人員提供指導,但它提供了一個將AI融入「評估」實務的框架。成功實施需要了解方案利害關係人(stakeholder)的需求、促進服務對象「參與」、確保工具可用性並保持有效溝通。雖然AI可以提高「評估」品質和創新能力,但必須謹慎處理AI演算法中的「倫理」考量和偏見。這些AI驅動的技術可以實現更穩健、基於證據的決策,從而支持正面的社會影響。

優勢 (Strengths)

- Ferretti(2023)指出,「ChatGPT」 有以下四項優點:(1)AI能編寫出精心設計的「評估邏輯模式」、方案概念及部門策略(如預測風險/限制),與某些真實能相媲美甚至更好;(2)它接受過重視包容性和多樣性價值的訓練(資訊匯集與統整),並提供闡明擴大「參與」和「責信」的想法;(3)它可以很容易地確定何時需要嚴格/客觀的研究及何時應該使用更多的「建構主義」方法;(4)它具有創造性,並運用各種溝通方式,以表明傳統的監測和「評估」方法可能不適合某些方案。

- GAI可以有效地分析數據並產生詳細的報告,並在人工評估所需時間的一小部分內提供客觀的回饋。此外,GAI可用於「評估」醫療介入措施的影響和「功效/效果」(effectiveness),讓使用者深入了解在醫療保健應用中使用AI的潛在益處和風險。生成式『化學』方法也正在開發中,以利用「深度學習」來預測分子結構,從而實現更有效率、更準確的材料評估。「生成對抗網路」(GAN)可用於偵測資料中的異常,並對複雜問題進行更準確的評估。與其他生成演算法相比,GAN具有許多優勢,例如效能更佳、訓練速度更快以及結果更準確。「行動應用程式」也可用於評估醫療效果,為使用者提供即時病情評估。生成模型可用於「評估」醫療狀況的不同特徵,例如「累積密度函數」(CDF)中資訊的均勻性。「深度狄氏程序混合模型」(DDPM)就是一個生成模型的例子,它比其他生成模型具有一系列優勢。最後,生成模型可用於評估AI演算法,從而對AI效能進行更準確、更全面的評估。總而言之,GAI有可能為「方案評估」帶來一系列優勢,為使用者提供更快、更準確、更可靠的結果(轉引自Patel, 2023)。

- AI能夠增強「可呈現性」(presentability),這意味著個人、倡議或組織能夠以最有利的視角展現自己;AI的「可洞察性」(insightability)意味著它能夠從大量數據中快速提取洞見。它還可能實現持續的“即時”「評估」,而不是目前許多「評估」中採用的「快照式」方法;AI另一個顛覆性的特性是其「可預測性」(forecastability)—它能夠利用模擬來識別可能發生的事情。AI的模擬潛力將重塑「事前評估」(在介入之前進行)(Duignan, 2024)。

劣勢 (Weaknesses)

- 「ChatGPT」擅長是概念,而不是事實。且不提供參考來源或連結,有時也可能會混淆標準或方法的名稱;它瞭解核心概念,並提供有價值的見解。但它不是搜索引擎,只呈現不同的參考範例(Ferretti, 2023)。

- 鑑於「評估」的核心之一,在於檢驗關於一項倡議的聲明是否準確,AI的「可呈現性」將為許多「評估」、品質保證和監管體系帶來問題。任何倡議,無論品質如何,現在都能夠提供近乎完美的文件。在產品和服務「評估」中,AI將能夠編造大量虛假的正面回饋。另一個問題是,人們將如何應對AI引發的「信任」危機。AI是否會迫使許多人進入有“防火牆”的社區/社群,以防範虛假資訊(資訊垃圾的海嘯)和虛假身分?(Duignan, 2024)。

- 另一個重要問題是「AI紅利」(即AI可能創造的財富)將如何分配。我們也應該考慮如何與AI夥伴建立健康的關係。當人們離開AI創造的完美烏托邦世界,渴望現實時,可能會出現「AI戒斷症候群」。有些人可能會尋求非AI體驗以及非AI融合的商品和服務,以應對AI飽和的世界(Duignan, 2024)。

機會 (Opportunities)

- GAI已在「方案評估」中應用一段時間,然而這個過程仍面臨許多挑戰。例如,「長短期記憶」(LSTM)網路在理解和生成英語以外的其他語言方面的能力仍不確定。儘管「自然語言處理」(NLP)領域取得了巨大進步,但生成式LSTM並非對所有語言都適用。這使得很難確定此類系統的準確性及其在「方案評估」中的可靠性。此外,自然語言生成是一項複雜的任務,需要對語言本身、語法和語義有深入的理解。確定此類系統的準確性和產生輸出的可靠性極具挑戰性。因此,開發一個全面的「評估」系統來測定GAI在「方案評估」中的「功效/效果」至關重要(轉引自Patel, 2023)。

- 「質性」資料資源豐富,但由於分析資源密集,經常被低估。AI輔助「質性分析」的各項工具,可以幫助我們更快地將有意義的洞察傳遞給「利害關係人」,而無需犧牲嚴謹性。在這個充滿複雜挑戰的世界裡,這似乎是一個值得探索的機會(Ehrlich, 2025)。

- 運用我們的能動性(agency)。鑑於所有這些挑戰,「評估」人員為何要接受AI技術?我們為何不該抵制?人們對AI的「倫理」和安全問題深感擔憂。然而,工業、金融和矽谷的車輪已然飛速運轉。無論喜歡與否,在我們看來,這股力量勢不可擋。如果「評估」的領域(就像其他所有領域一樣)想要在所有知識型工作領域即將到來的變革中生存下來,就必須做好迎接變革的準備。我們必須適應,否則就會被時代淘汰——就像現代「評估」人員如果還在使用打字機、計算尺和複寫紙,最終會面臨同樣的命運一樣。美國經濟學家-布萊恩·卡普蘭在最近一次關於AI的採訪中表示:「所有進步都會對某些人產生負面影響。疫苗對殯儀館來說就是壞事。但一般來說,任何能夠提高人類生產力的事物都有利於人類的生活水平」(Cantor, 2023)。雖然這在平均水平上可能是正確的,但它也忽略了一個事實:新技術會帶來新的不平等和人類苦難。我們能夠也應該積極主動,為整個社會,尤其是「評估」人員,制定新的「倫理」標準。雖然改變不可避免,我們確實有理由保持樂觀,但這並不代表我們可以放鬆警惕,放手不管。我們必須運用自身的力量,規劃出一條通往公正、公平的AI應用之路(轉引自Kates & Wilson,, 2023)。

威脅 (Threats)

- 使用GAI的潛在缺點,例如其可能存在的偏見以及「評估」過程的主觀性(Mondal et al., 2023)。

- 產出、產出、再產出。一項能夠產生無盡報告的技術,很可能會改變報告本身的性質。報告會失去意義嗎?如果能夠將數據輸入到產生報告的AI工具中,「評估」成本將大大降低。AI產生的報告確實可以為方案管理者提供一些有用的回饋——尤其是對於那些資源匱乏、無法進行更深入「評估」的方案管理者而言。然而,這也可能給「評估」人員和方案管理者帶來新的問題。良好的「評估」始終需要謹慎建構和執行。不考慮理論或實務、不考慮所使用的基本評估邏輯或標準的「評估」,可能會被證明是無用的、誤導的,甚至是有害的。例如,至少在短期內,AI不太可能能夠識別「評估」設計中的嚴重缺陷或偏見。這種自動化可能會導致「評估」過程的空洞化,這對方案來說也將是巨大的損失。Patton(2011)認為,「評估」的「過程應用」除了簡單的評估結果之外,還能為組織帶來層層遞進的效益。如果「評估」的創建過程缺乏“人為”參與,這種寶貴的「過程應用」就會被徹底侵蝕(轉引自Kates & Wilson,, 2023)。

- 市場顛覆與新角色湧現。隨著「評估」產品的進入門檻降低,對「評估」人員的需求會下降嗎?那些最善於利用AI技術的大型「評估」公司會不會進一步擴大其主導地位?如果AI導致「評估」產品的平均品質和實用性下降,社會是否會對整個「評估」行業產生懷疑?雖然這些結果是可以想像的,但絕非不可避免。不妨想想ATM提款機興起後銀行業發生的著名案例:這項技術實際上(至少在其誕生後的前三十年)帶來了更多的櫃員職位(Pethokoukis, 2016)。這些可能性促使我們思考未來可能採取的其他發展路徑。例如,「評估」可能會變得更便宜,從而讓更多組織更容易獲得。這是否會為小型營利性組織開啟一個「評估」的黃金時代?或者,營利企業或社會企業是否會擴大對「評估」的使用?或者也許它將為那些有能力的人提供開發更大、資訊更豐富的「評估」流程的能力(轉引自Kates & Wilson,, 2023)。

- 「對齊」(alignment)問題。AI設計的不可預測性—一個人類無法窺視的黑盒子—這項挑戰。這對人類決策及其相關現實世界後果的AI影響實在令人擔憂。如果沒有切實可行的方法來理解AI設計的細節,人類將幾乎無法以我們認為符合自身價值觀的方式推動這一進程—例如「公平」。這一困境對眾所周知的「對齊」問題有著巨大的影響。也就是說,如果我們無法確定一個系統究竟是如何運作的,我們就無法確定它是否符合我們的價值觀。同樣複雜的是:對於一個將在如此眾多的脈絡、如此眾多的情境和如此眾多的文化中運作的系統,我們如何才能在如此大規模的範圍內達成一套一致的價值觀?令人震驚的是,這個關於AI和價值觀「對齊」的核心問題本質上是一個「評估性」問題,而「評估」領域擁有獨特的優勢來解答這個問題。這或許並不令人意外,因為Scriven(2013)曾斷言,「評估」是一項基本的認知活動,在過去的長久歷史裡存在於我們人類身上,也存在於其他物種身上。因此,當我們建造一台旨在模仿甚至超越人類智力的機器時,我們理所當然地會面臨這些挑戰(轉引自Kates & Wilson,, 2023)。

- 使用GAI進行「方案評估」的潛在風險不容忽視。組織機構應意識到第三方開發者可能會使用GAI,並且有可能在不知情的情況下使用其輸出,因此必須考慮合作夥伴的「管理措施」。GAI工具有潛在的「倫理」風險,需要在「方案評估」期間仔細考慮。例如,開發GAI系統所使用的資料可能會影響「智慧財產權」,包括著作權保護和所有權。此外,某些GAI模型會「複製」其提取的內容,這可能會導致錯誤地為特定程式碼段產生新的解決方案許可證。組織機構也應對用於開發GAI工具的框架進行盡職調查,以了解其潛在的缺陷。在開始試驗GAI模型時,監管環境的改變至關重要。儘管存在風險,但只要在發布或使用之前對輸出進行人工檢查,GAI模型仍然可以安全使用。為了最大限度地降低風險,組織可以客製化GAI工具,以滿足其需求並避免偏差。隨著該技術的應用越來越廣泛,監管環境也將發生變化,新的模型將被引入並定期測試。組織也應意識到,GAI模型的前景仍然非常難以預測,他們應該確保用於訓練模型的資料是無偏差的(轉引自Patel, 2023)。

※ S-O 積極策略 W-O 翻轉策略 S-T 多角策略 W-T 防禦策略

『人工智慧』應用於「方案評估」的實例

Shapiro和Lam(2025)提供六種方法(或步驟)為「方案評估」人員創建了一個框架,以利用AI的強大能力,促進更有洞察力和效率的「評估」和報告。如以下所示:

- 【方法一】─辨識資料模式

AI擁有無與倫比的能力,能夠分析大量資料集並發現人工方法難以識別的「模式」(Provost & Fawcett, 2013)。這種能力在「方案評估」中尤其重要,因為資料量龐大且複雜程度高,傳統的分析技術難以應付。透過利用AI,「評估」人員可以發現趨勢、相關性和異常值,從而更深入地了解方案動態,並洞察導致方案成功或失敗的因素。以一項旨在降低參與者糖尿病狀況的健康方案為例。透過將AI演算法應用於患者數據,「評估」人員可以識別隨時間推移的健康結果模式,例如血糖水準、服藥遵從性和就診頻率的趨勢。這種分析可以揭示該方案是否有效地管理了糖尿病,並可以找出導致正面或負面結果的具體因素。AI發現的模式可以指導進一步的改善,使「評估」人員能夠提出可能提高方案有效性的改進建議,例如增加患者支持或修改處遇計畫。AI的「模式」識別能力可以促進數據驅動的方法來理解和提高方案績效。

- 【方法二】─預測未來結果

預測性AI模型可以根據現有數據預測業務方案和計劃的未來「結果」,為「評估」人員提供寶貴的見解。此功能有助於「評估」方案的長期影響,並預測可能影響方案成功的未來趨勢(T. Davenport & Harris, 2017)。例如,在「評估」新進員工培訓方案的「功效/效果」時,業務分析師可以使用預測模型(predictive modelling)來預測該方案對員工工作績效、留任率和生產力的長期影響。透過準確預測培訓方案的「結果」,分析師可以更了解潛在的長期「效益」(benefits)和投資回報。這可能包括預測該方案將如何影響「關鍵績效指標」,例如銷售額、客戶滿意度或營運效率。憑藉這些數據驅動的預測,企業可以就繼續、擴展或修改培訓方案做出更明智的決策,以最大限度地發揮其影響力。預測分析也能幫助「評估」人員預測可能影響業務方案成功的未來市場狀況和產業趨勢。例如,分析師可以利用AI預測客戶偏好的變化、競爭對手策略的轉變,或可能擾亂公司營運的新技術的出現。憑藉這些洞察,企業可以主動調整其方案和計劃,保持領先地位,並抓住即將到來的機會。

- 【方法三】─發現可改善的區塊或範圍

AI可以精準定位方案表現不佳或突出的區塊(或範圍)。這種洞察使「方案評估」人員能夠提出明智的改進建議。例如,如果某個培訓課程的中輟/流失率很高,AI可以幫助識別「挑戰性模組」(challenging modules)或其他導致這一趨勢的因素,從而指導課程調整或加強支持。透過利用AI的分析能力,「方案評估」人員能夠更好地理解推動方案「結果」的因素。例如,在分析一個中輟/流失率高的培訓方案時,AI可以幫助精準定位導致這一趨勢的具體模組或面向。AI可能會發現培訓方案中的某些模組對參與者來說尤其具有挑戰性,導致中輟/流失率上升。此外,AI還可以發現其他促成因素,例如支持機制不足或教學材料過時。基於這些信息,「方案評估」人員能夠制定明智的改進建議,例如修改課程以使「挑戰性模組」更易於理解,或增強支持服務以滿足參與者的「需求」。

- 【方法四】─提供視覺化

- 【方法五】─自動化資料分析

- 【方法六】─利用AI建立直觀的數據儀表板或控制面板

直觀的數據儀表板(或控制面板),在「方案評估」中發揮著至關重要的作用,它能夠提供即時監控,並幫助「評估」人員動態追蹤方案績效(Alborhamy, 2020)。借助AI,「評估」人員可以建立直觀的數據儀表板,提供易於使用的介面來存取和分析數據。這些儀表板使「評估」人員能夠即時監控方案指標的進展,從而促進及時決策和調整(Solanki, Jain, & Jadiga, 2024)。AI生成儀表板可以顯示與方案「結果」相關的「關鍵績效指標」和衡量標準,例如參與者參與度、完成率和滿意度。透過即時「視覺化」這些數據,「評估」人員可以獲得關於方案「功效/效果」的寶貴見解,並及時發現需要改進的區塊或範圍。此外,「互動式過濾器」(interactive filters)和可自訂視圖等直觀的功能,使「評估」人員能夠根據不斷變化的需求和優先順序調整分析。

『人工智慧』應用於「方案評估」的倫理議題

在思考AI的「倫理」(ethics)議題時,理解其目的和意圖至關重要。例如,數位技術高度靈活,可供多種解讀。它們在邏輯上具有可塑性。因此,它們可以用於無數種用途,這些用途可能與原始開發者和設計者的意圖一致,也可能不一致。儘管AI具有這種開放性,但我們仍然可以區分決定系統設計、開發和使用的不同目的。上圖展示了關於AI三種不同目的之重疊性:提高「效率」的AI、「社會控制」的AI,以及作為前兩個目的的替代和補充,促進「人類心盛」(human flourishing)的AI。這三個目標可能相互衝突,但並非必然矛盾(Stahl, 2021)。

追求「效率」及其帶來的經濟效益可以帶來強勁的經濟,為人類幸福(well-being)提供物質基礎。高「效率」的經濟透過創造財富,開闢了人類「心盛」的途徑,而這在以往是不可能實現的。例如,從煤炭能源生產轉向太陽能的成本很高。此外,追求「效率」和創造利潤可以成為追求卓越的正當活動領域,人們可以在這種活動中蓬勃發展(Stahl, 2021)。

「社會控制」常被視為問題重重,與「個人自由」相衝突。「資訊和通訊技術」(ICT)的使用,長期以來一直與侵犯隱私和監控的加劇聯繫在一起 (Lyon, 2001)。這種擔憂傳統上將「國家」視為監控的來源。如今,企業巨頭控制著AI所需的大量資料和技術基礎設施,人們的擔憂還包括在新形式的『監控資本主義』(Surveillance capitalism)中對個人的剝削(Zuboff, 2019)。但同樣,「社會控制」與人類「心盛」之間也不一定有矛盾。人類作為社會存在,需要定義合作的方式,包括對「道德準則」(moral codes)的認同,而這些需要以某種方式控制和執行。雖然「助推」(nudging)作為一種政策工具存在爭議,但它可以而且經常被用來促進有利於「心盛」的行為,例如提倡更健康的生活方式。「助推」策略特別在英國、澳洲、德國和美國使用(Benartzi et al., 2017),它是指政府主導的旨在實現既定目標(例如提高疫苗接種率)的活動。例如,美國的一項活動向公民發送了流感疫苗接種計劃提示,結果疫苗接種率提高了4.2%(轉引自Stahl, 2021)。

在『科技』領域,AI可以用來提升隱私的意識覺察(Acquisti, 2009),這可以說是「心盛」發展的條件。例如,全球大部分地區曾因新冠(COVID-19)疫情而處於封鎖狀態。在英國,圍繞著用於追蹤和追蹤感染者的應用程式展開了激烈的爭論(Klar & Lanzerath, 2020)。這表明,即使是透過數位技術進行強制性的「社會控制」,在某些情況下也可能有利於人類的「心盛」發展,例如,如果它能夠幫助拯救生命並使社會正常運作。因此,上列的文氏圖(Venn Diagram)可能更能反映這三個目的之間的重疊關係(轉引自Stahl, 2021)。

迄今為止發布的最全面的「AI倫理」指南綜述(Jobin et al. 2019)列出了以下「倫理」原則:透明度、正義與公平、不傷害、責任、隱私、行善、自由與自主、信任、可持續性、尊嚴與團結。每一項原則都包含若干組成部分。例如,透明度指的是可解釋性、可闡釋性、可理解性、可闡釋性、溝通和揭露等相關概念。這些概念之間的關係通常沒有明確的定義,它們可能指涉不同的「倫理」立場(轉引自Stahl, 2021)。

另一個例子是,歐盟AI高級專家小組(2019年)提出的『可信AI倫理指南』,其包含一系列相關原則。專家小組提出了一個「可信賴的AI」(Trustworthy AI)框架,涵蓋AI的合法性、倫理性和健全性。此框架基於四個「倫理」原則:尊重人類自主權、預防傷害、公平性和可解釋性。專家小組從這些原則中推導出實現「可信賴的AI」的七項關鍵要求,如以下所示(轉引自Stahl, 2021):

- 人類的能動性和監督

- 技術穩健性和安全性

- 隱私和資料的治理

- 透明度

- 多元、非歧視性和公平性

- 社會與環境的幸福

- 責信

在此基礎上,他們發展了「可信賴的AI」的「評估」方法和政策建議。

將AI融入「方案評估」有望推動「循證」(evidence-based)的決策,並提高社會方案、政策和介入措施的「功效/效果」。透過利用AI分析複雜資料集並獲得切實可行的洞見,「評估」人員可以更好地應對社會挑戰,並為正向的「社會變革」做出貢獻。然而,在將AI融入「方案評估」的過程中,務必謹慎行事,並考慮「倫理考量」(ethical considerations)、隱私問題以及AI演算法固有的潛在偏見。「倫理考量」包括AI決策的透明度、保護敏感資訊以及遵守資料保護法規。為了解決這些問題,「評估」人員應透過記錄和報告其AI方法的使用情況來保持透明度(Shapiro & Lam, 2025)。

『人工智慧』應用於「方案評估」的未來方向

「方案評估」中有許多數據分析工具可供選擇。儘管市場上競爭激烈的工具種類繁多,但主要重點應放在與「客戶」和「利害關係人」建立有效的聯繫上。可以使用標準工具(Islam, 2020)建立類似的數據儀表板或控制面板來探索方案數據,這些工具包括「Microsoft Excel」、「Microsoft PowerBI」、「Tableau」以及許多其他套裝軟體。透過優先考慮客戶參與度並瞭解他們的具體需求,「方案評估」人員可以確保所選工具與「評估」目標相符。這種方法可以增強信任和協作,並確保「評估」過程具有相關性和影響力。利用新的先進工具,尤其是基於AI和ML的工具,例如「ChatGPT」的「資料分析師」(Data Analyst)模組(Hassani & Silva, 2023; Rasheed et al., 2024),可以顯著提高方案資料分析的品質和深度。這些工具提供了強大的功能,能夠識別趨勢、預測結果、發現改進區塊(或範圍)和「視覺化」數據,豐富從評估中獲得的見解並支持更明智的決策(轉引自Shapiro & Lam, 2025)。

面對這波來勢洶洶、無法抵擋的AI新時代,從事「方案評估」相關專業者有何與時俱進因應作為呢?如果我們只是習慣進行「過程評估」(如場次/人次/人數),或製作精美的圖表與封面的paper work,未來就極容易被AI所取代;簡單來說,AI僅是「餵什麼跑出什麼」(Garbage in, Garbage out),雖然它有「深度學習」功能,但「評估」方案是針對“事實”,而非只是一個藍圖;AI是從海量資料中來增強與優化其「模組」,故本質屬於「公民參與」與「賦權」(Empowerment),此乃目前諸多「評估」人員無法做到的;AI是一種知識的“解放”(Liberation)運動,其是釋放我們自己的創造力並觸及廣大新受眾的好方法;在談論變革時,AI可在方案的監控、「評估」和規劃上,添加一個全新的“溝通維度”。

雖然「ChatGPT」 只是一個程式,無法正確辨識現實中的人物,因為它缺乏人之為人的情感能力與價值觀。但AI對於「評估」專業領域的巨大衝擊,不會在遙遠的未來實現,它已經是正在發生的進行式了。而我們要向下一代的專業人士/學生傳授什麼?還是那些傳統的由上而下、專家權威、菁英觀點、便宜行事、虛有其表、蕭規曹隨、機械式思考嗎?!

- Jacob, S. (2025). Artificial Intelligence and the Future of Evaluation: From Augmented to Automated Evaluation. Digital Government: Research and Practice, 6(1), Article No.10, 1-10.

- Bamberger, M. (2020). The culture of evaluation in the age of big data: The need for a new evaluation paradigm for the 4th industrial revolution. Evaluation Matters, Q1, 74-85.

- Shapiro, S., & Lam, V. (2025). Artificial Intelligence in Program Evaluation: Insights and Applications. Canadian Journal of Program Evaluation, 39(2), 382-391.

- Ferretti, S. (2023). ChatGPT: Considering the Role of Artificial Intelligence in the Field of Evaluation (Part 1). The AEA365 blog.

- Izdihar, K., Karim, M. K. A., Aresli, N. N., Radzi, S. F. M., Sabarudin, A., Yunus, M. M., Rahman, M. A. A., & Shamsul, S. (2021). Detection of novel coronavirus from chest X-Ray radiograph images via automated machine learning and CAD4COVID [Paper presentation]. 2021 International Congress of Advanced Technology and Engineering (ICOTEN), Taiz, Yemen.

- Lohit, V. S., Mujahid, M. M., & Sai, G. K. (2022). Use of machine learning for continuous improvement and handling multi-dimensional data in service sector. Computational Intelligence and Machine Learning, 3(2), 30-35.

- Mueller, B., Kinoshita, T., Peebles, A. T., Graber, M. A., & Lee, S. (2022). Artificial intelligence and machine learning in emergency medicine: A narrative review. Acute Medicine & Surgery, 9(1), e740.

- Stahl, B. C. (2021). Artificial Intelligence for a Better Future: An Ecosystem Perspective on the Ethics of AI and Emerging Digital Technologies (SpringerBriefs in Research and Innovation Governance). Springer International Publishing, Open Access Book.

- McCarthy, J., Minsky, M. L., Rochester, N., & Shannon, C. E. (2006). A proposal for the Dartmouth summer research project on artificial intelligence. AI Magazine, 27:12-14.

- Kaplan, A., & Haenlein, M. (2019). Siri, Siri, in my hand: who’s the fairest in the land? On the interpretations, illustrations, and implications of artificial intelligence. Bus Horiz, 62:15-25.

- Elsevier. (2018). ArtificiaI intelligence: how knowledge is created, transferred, and used. Trends in China, Europe, and the United States. Elsevier, Amsterdam.

- Gasser, U., & Almeida, V. A. F. (2017). A Layered Model for AI Governance. IEEE Internet Computing, 21(6), 58-62.

- Bishop, C. M. (2006). Pattern recognition and machine learning. Springer Science+Business Media, New York.

- Alpaydin, E. (2020). Introduction to machine learning. The MIT Press, Cambridge MA.

- Moor, J. H., & Bynum, T. W. (2002). Introduction to cyberphilosophy. Metaphilosophy, 33:4-10.

- Floridi, L. (1999). Information ethics: on the philosophical foundation of computer ethics. Ethics and Information Technology, 1:33-52.

- European Commission. (2020). Report on the safety and liability implications of artificial intelligence, the internet of things and robotics. European Commission, Brussels.

- Stahl, B. C., & Wright, D. (2018). Ethics and privacy in AI and big data: implementing responsible research and innovation. IEEE Security & Privacy, 16:26-33.

- Bajotra, V., & Rani, N. (2024). The Role of Artificial Intelligence in Psychology. Far Western Journal of Education, 1, 35-46.

- Patel, D. (2023). Revolutionizing Program Evaluation with Generative AI: An Evidence-Based Methodology. International Journal For Multidisciplinary Research, 5(3): 11.

- Duignan, P. (2024). Tech TIG Week: Why Evaluators (and Everyone Else) Need a New Way of Talking about AI. The AEA365 blog.

- Ehrlich, V. (2025). Integrating Technology in Evaluation TIG Week: Talking to Our Data: Conversational Analysis with AI Tools. The AEA365 blog.

- Cantor, M. (2023, April 7). This economist won every bet he made on the future. Then he tested ChatGPT. The Guardian.

- Kates, A. W., & Wilson, K. (2023). AI for Evaluators: Opportunities and Risks. Journal of MultiDisciplinary Evaluation, 19(45), 99-104.

- Patton, M. Q. (2011). Essentials of utilization-focused evaluation. SAGE Publications.

- Pethokoukis, J. (2016, June 6). What the story of ATMs and bank tellers reveals about the ‘rise of the robots’ and jobs. AEIdeas.

- Scriven, M. (2013). The foundation and future of evaluation. In S. I. Donaldson (Ed.), The future of evaluation in society: A tribute to Michael Scriven (pp. 11-44). Information Age Publishing.

- Wang, K., Gou, C., Duan, Y., Lin, Y., Zheng, X., & Wang, F. Y. (2007). Generative adversarial networks: introduction and outlook. IEEE/CAA Journal of Automatica Sinica, 4(4), 588-598.

- Mondal, S., Das, S., Vrana, V. G. (2023). How to Bell the Cat? A Theoretical Review of Generative Artificial Intelligence towards Digital Disruption in All Walks of Life. Technologies, 11(2), 44.

- Narayan, R. (2020). Leveraging Digital Intelligence for Community Well-Being. International Journal of Community Well-Being, 3, 539-558.

- Kjell, O., Giorgi, S., Schwartz, H. A., & Eichstaedt, J. C. (2023). Towards Well-Being Measurement with Social Media Across Space, Time and Cultures: Three Generations of Progress. In World Happiness Report 2023 (11th ed., Chapter 5). Sustainable Development Solutions Network.

- Wu, A., Stouffs, R., & Biljecki, F. (2022). Generative Adversarial Networks in the built environment: A comprehensive review of the application of GANs across data types and scales. Building and Environment, 223:109477.

- Koshino, K., Werner, R., Pomper, M., Bundschuh, B. A., Toriumi, F., Higuchi, T., & Rowe, S. P. (2021). Narrative review of generative adversarial networks in medical and molecular imaging. Annals of Translational Medicine, 9(9):821.

- Xu, J., Li, H., & Zhou, S. (2014). An Overview of Deep Generative Models. IETE Technical Review, 32(2), 131-139.

- Zhang, C., Zhang, C., Zheng, S., Qiao, Y., Li, C., Zhang, M., ... & Hong, C. S. (2023). A Complete Survey on Generative AI (AIGC): Is ChatGPT from GPT-4 to GPT-5 All You Need?. arXiv preprint arXiv:2303.11717.

- Provost, F., & Fawcett, T. (2013). Data science for business: What you need to know about data mining and data-analytic thinking. O’Reilly Media.

- Davenport, T., & Harris, J. (2017). Competing on analytics: Updated, with a new introduction: The new science of winning. Harvard Business Press.

- Davenport, T. H., & Kirby, J. (2016). Only humans need apply: Winners and losers in the age of smart machines. Harper Business.

- Alborhamy, Y. (2020). How do data dashboards affect evaluation use in a knowledge network? A study of stakeholder perspectives in the Centre for Research on Educational and Community Services (CRECS) [Master’s thesis]. University of Ottawa.

- Solanki, A., Jain, K., & Jadiga, S. (2024). Building a data-driven culture: Empowering organizations with business intelligence. International Journal of Computer Trends and Technology, 72(2), 46-55.

- Lyon, D. (2001). Surveillance society: monitoring everyday life. Open University Press, Buckingham, UK.

- Zuboff, P. S. (2019). The age of surveillance capitalism: the fight for a human future at the new frontier of power. Profile Books, London.

- Benartzi, S., Beshears, J., Milkman et al. (2017). Should governments invest more in nudging?. Psychological Science, 28(8), 1031-1040.

- Klar, R., & Lanzerath, D. (2020). The ethics of COVID-19 tracking apps: challenges and voluntariness. Research Ethics, 16(3-4):174701612094362.

- Jobin, A., Ienca, M., & Vayena, E. (2019). The global landscape of AI ethics guidelines. Nature Machine Intelligence, 1:389-399.

- European Parliament. (2020). Draft report with recommendations to the Commission on a framework of ethical aspects of artificial intelligence, robotics and related technologies. European Parliament, Committee on Legal Affairs.

- Islam, M. (2020). Data analysis: Types, process, methods, techniques and tools. International Journal on Data Science and Technology, 6(1), 10-15.

- Hassani, H., & Silva, E. S. (2023). The role of ChatGPT in data science: How AI-assisted conversational interfaces are revolutionizing the field. Big Data and Cognitive Computing, 7(2), 62.

- 周才忠 (2025)。「社區心理學實務教學資源手冊」(第一版)。

- 周才忠 (2024)。「台灣心理專業者的未行之路」(第五版)。

- 《『社區科學』的過去.現在.未來》專輯(I):近5000年的『科學』史摘述、「科學革命」的誕生與其影響 (2025.5.17)

- 《『社區科學』的過去.現在.未來》專輯(II):『心理學』作為一門『科學』的歷史觀點 (2025.5.23)

- 《『社區科學』的過去.現在.未來》專輯(III):「科學革命的結構」—『典範轉移』的定義、循環、影響和範例 (2025.5.26)

- 《『社區科學』的過去.現在.未來》專輯(IV):「科學哲學」的定義與演進,以及對『社區科學』研究實踐的影響 (2025.6.3)

- 《『社區科學』的過去.現在.未來》專輯(V):『社區科學』的定義、特徵,以及與『心理學』領域的交集 (2025.6.6)

- 《『社區科學』的過去.現在.未來》專輯(VI):生態效度、心理政治效度、社區研究和行動的綜合生態模式 (2025.6.11)

- 《『社區科學』的過去.現在.未來》專輯(VII):彌合『科學』與實踐之間的差距─『預防科學』新典範、「以社區為中心」模式、推廣和實施的「互動系統架構」(ISF) (2025.6.15)

- 《『社區科學』的過去.現在.未來》專輯(VIII):捕捉「社區」脈絡的『科學』方法─多層次模式(MLM)、地理資訊系統(GIS)、社會網絡分析(SNA)和集群分析(CA) (2025.6.20)

- 《『社區科學』的過去.現在.未來》專輯(IX):「方案評估」和『科學』之間的關係─「評估」的歷史演進、「方案評估」的定義/目的/哲學觀/邏輯、「結果」和「影響」評估的區別與實例、「獲得結果」(GTO)的責信 (2025.6.26)

沒有留言:

張貼留言